DeepFaceLab 不同像素模型效果对比!

模型的像素是128好还是256好,这两个差多少?这样的问题很常见!

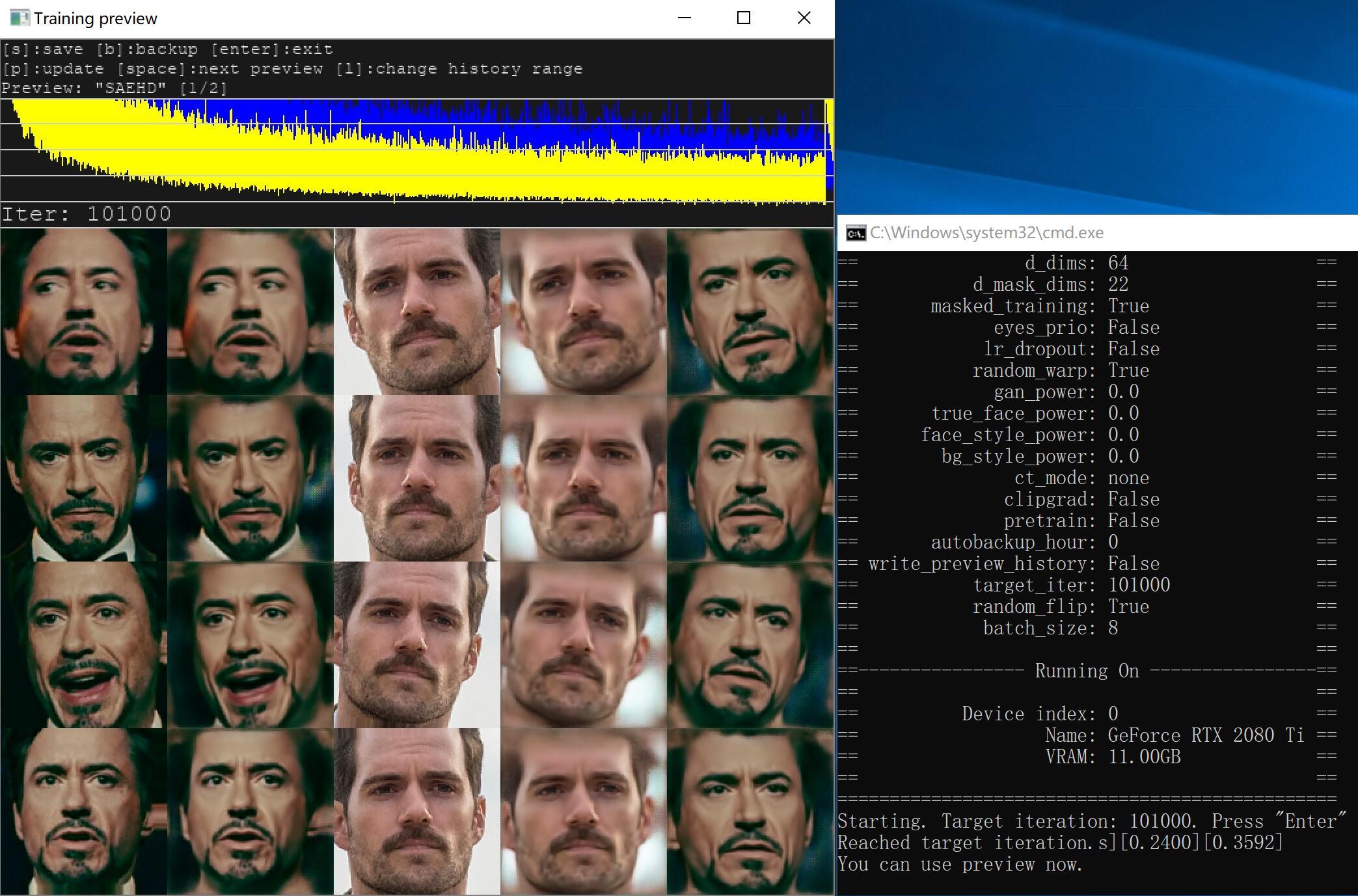

为了对像素这个参数有一个直观的认知,我花了一周时间跑了5个10万迭代的模型,这些模型分别是:Quick96, SAEHD128(DF/DFHD), SAEHD196, SAEHD256。素材是一模一样的,都是软件自带的默认素材。

下面就来看一下各个模型跑到10万迭代时的预览图。

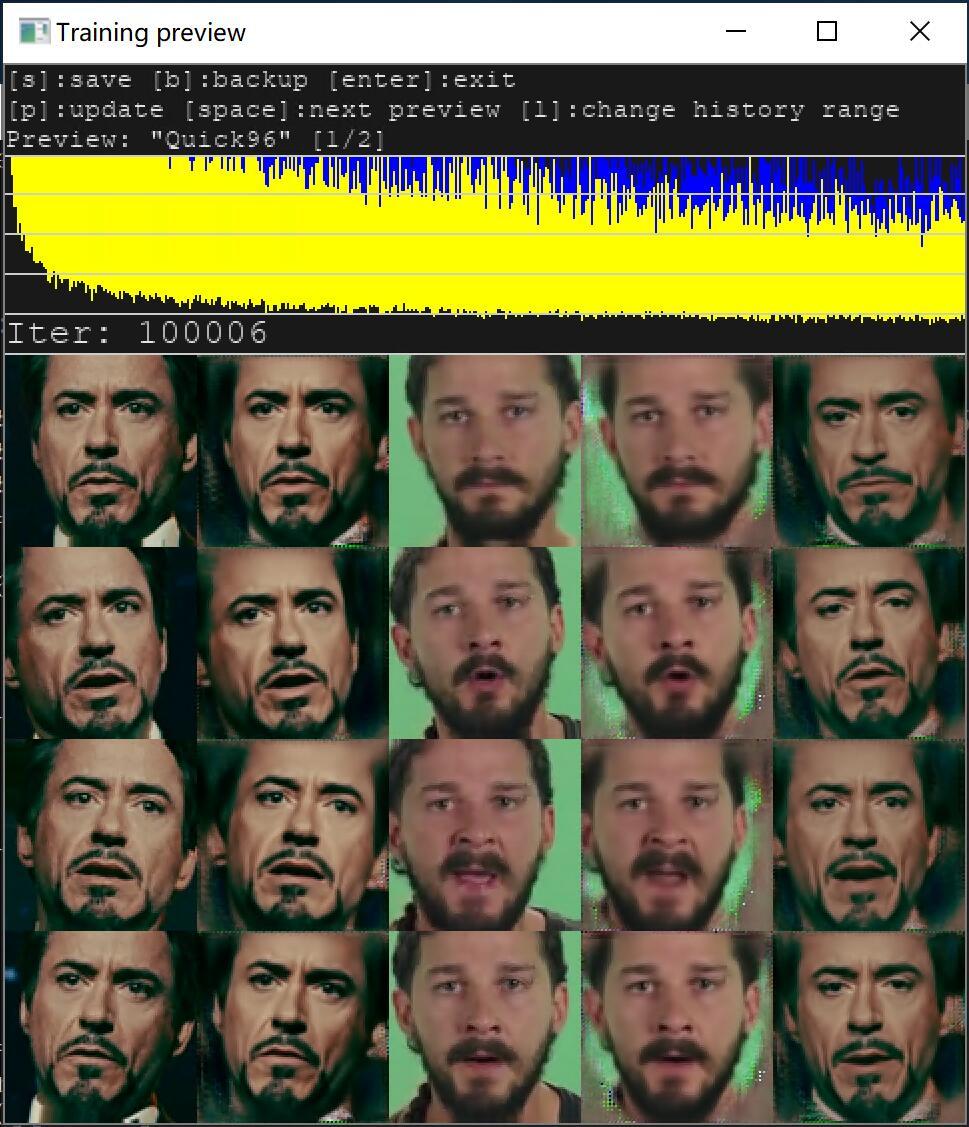

Quick96

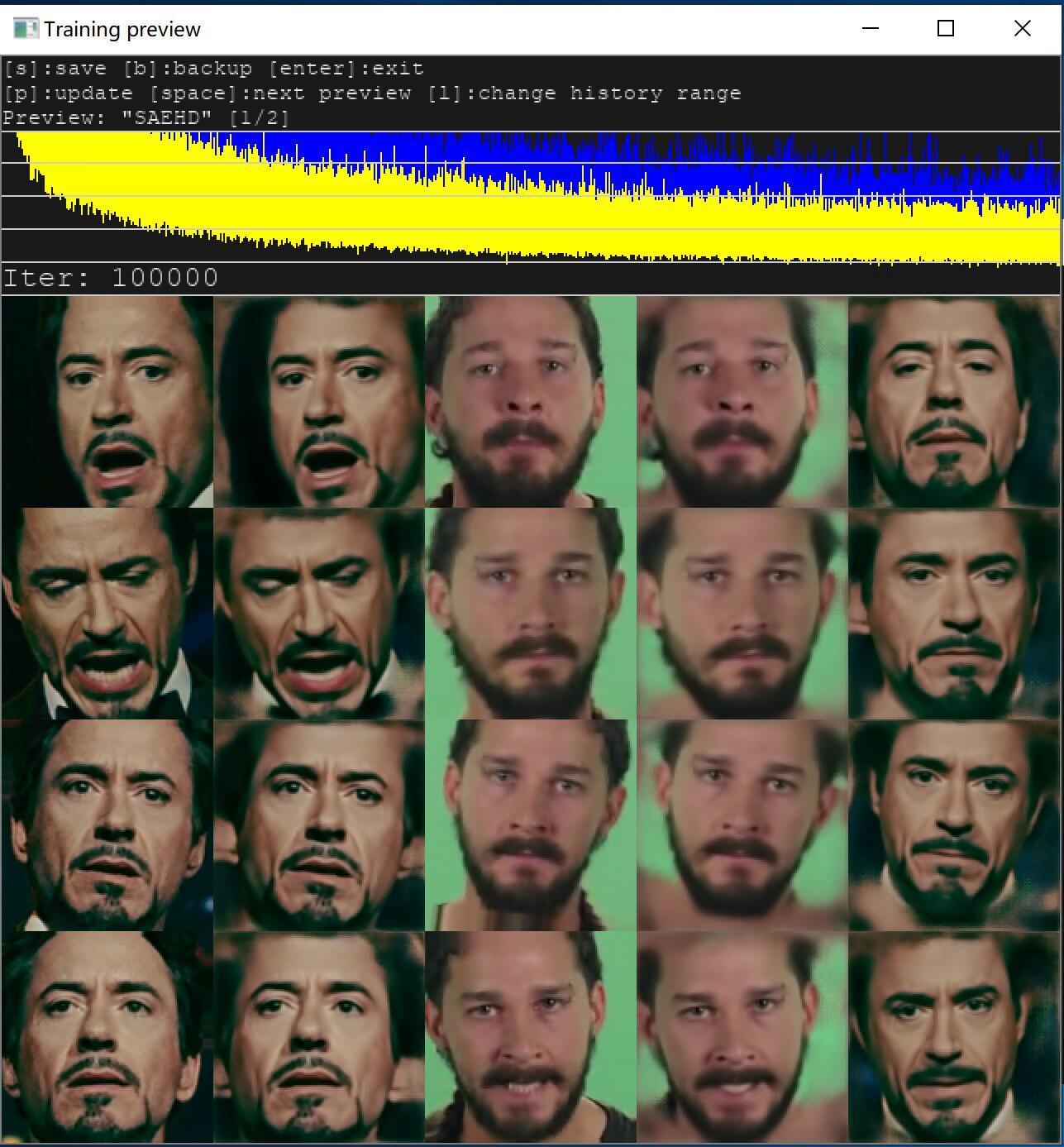

SAEHD128

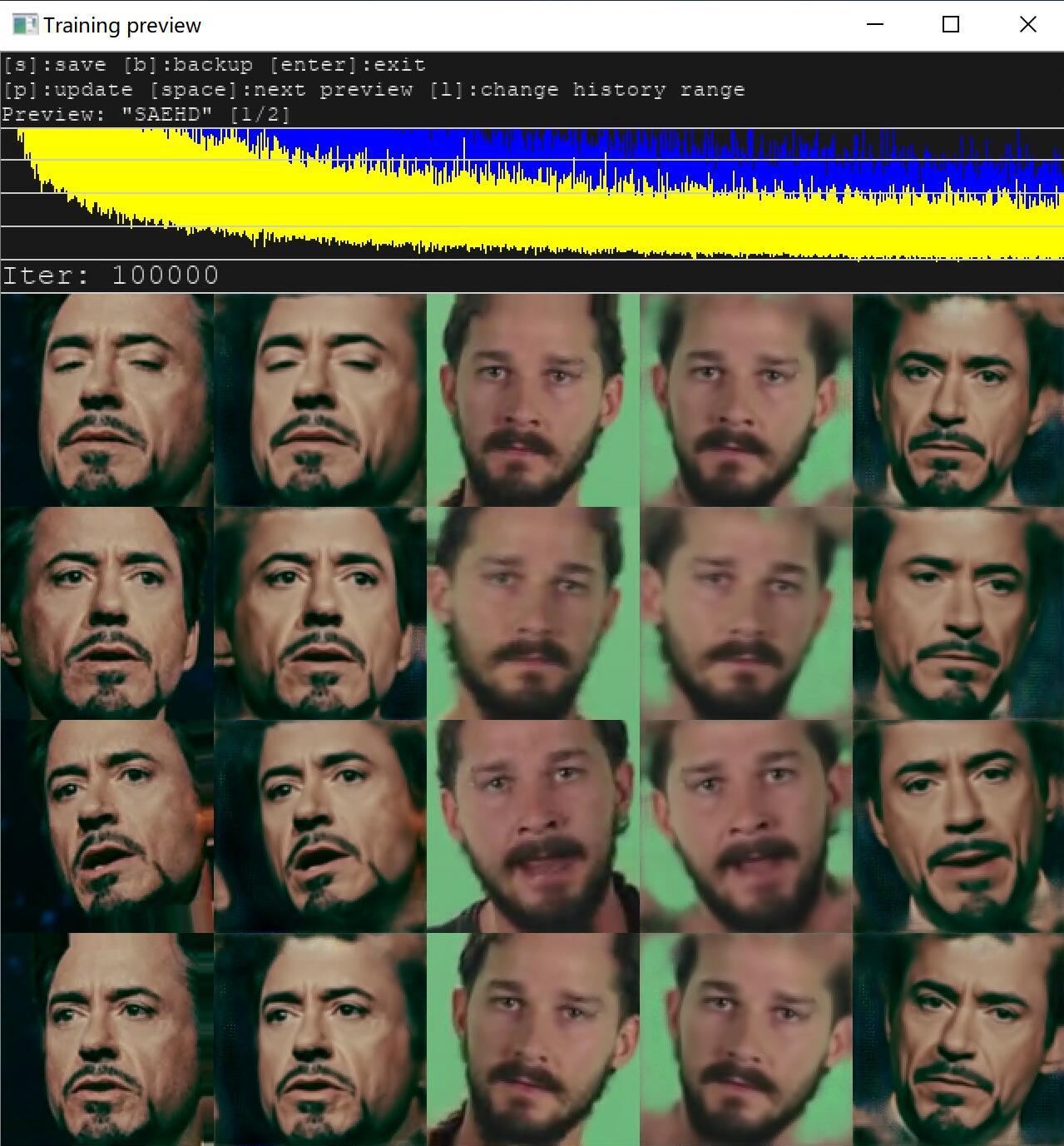

SAEHD128 DFHD

SAEHD192

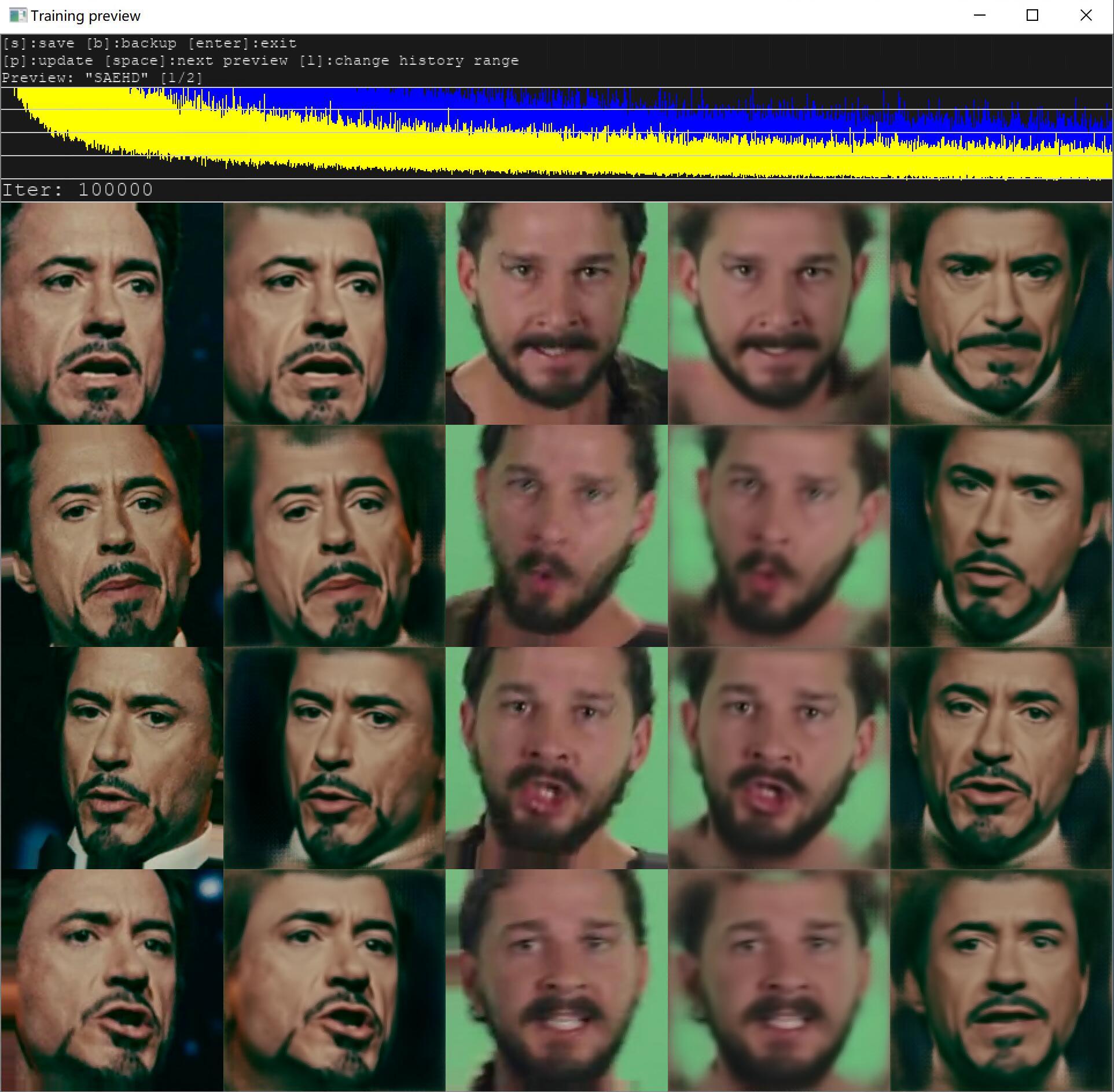

SAEHD256

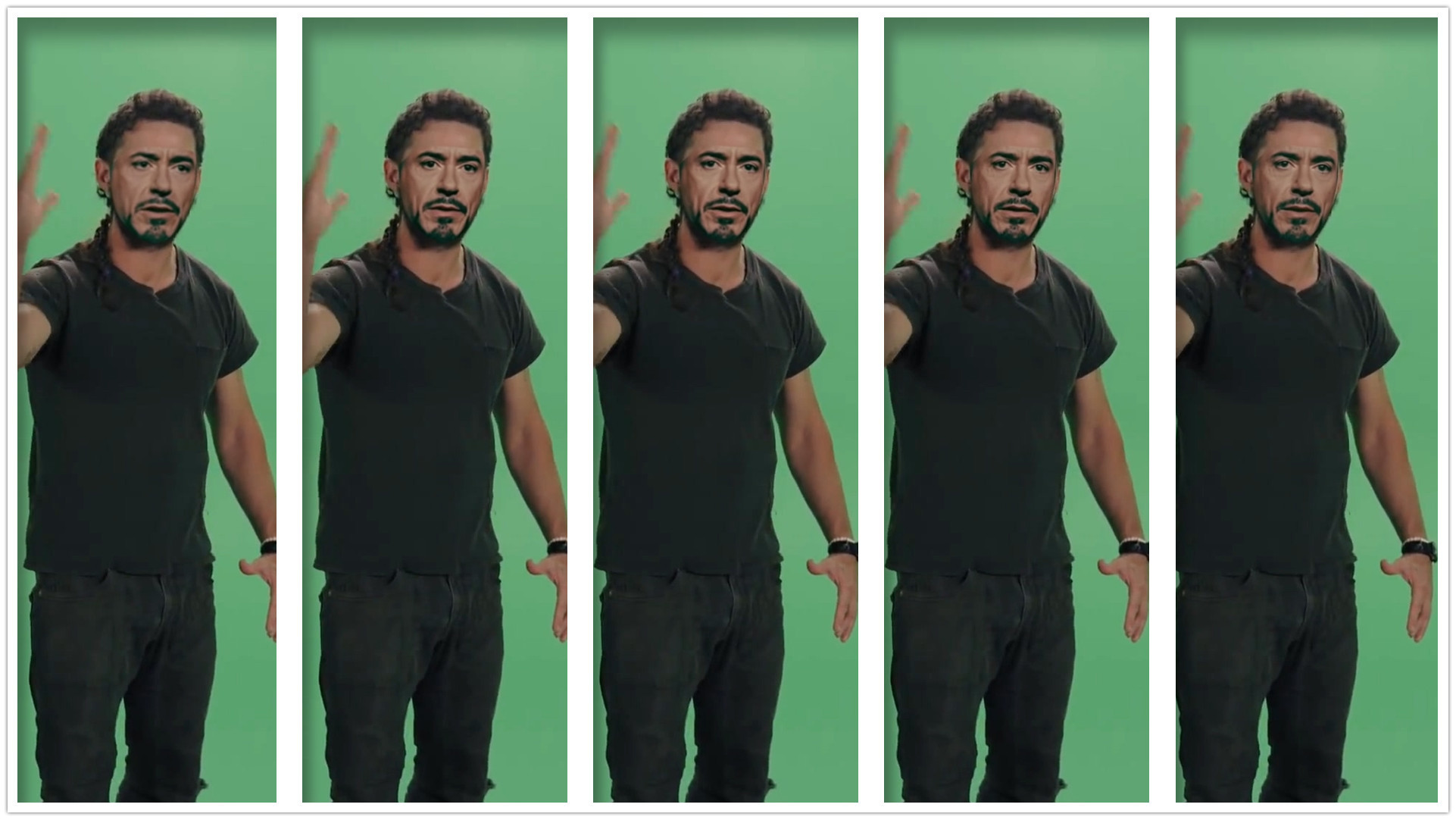

然后我将每个模型都合成了一个视频,合成参数基本默认,特地留了面具边缘,这样比较好对比。下面看下合成图片。

result_quick96

result_DF128

DFHD128

result_DF192

result_DF256

从左到右分别是:quick96->df128->dfhd128->df192->df256 (看到最后有点晕!)

从对比图来看,就demo素材而言,跑到10万迭代已经有不错的效果了,无论是哪个模型,哪种像素。

相比而言,Quick96的效果和SAEHD差别比较明显。前者的脸色会比较惨淡一些,清晰度也会差一些。而SAEHD不同像素之间的差别好像不是很明显。DFHD和DF结构,似乎也没有体现出什么差别,我甚至觉得默认的DF效果更好,而DFHD的时间却多出了很多很多。SAEHD256融合度好像要好一些。

这里可以简单得出一个结论:针对demo素材而言,用不同模型跑到10万迭代之后合成的效果之间差异并没有那么明显。所以不要太迷信高参数,这里并没有云泥之别。

当然,以上的对比也是有一些问题。

第一:同样跑10万迭代,看似很公平,其实不公平。

因为每个模型跑到10万迭代的时间是完全不一样的,Quick96消耗的时间最少,SAEHD256时间最多。两者相差时间可不是一丁半点。

还有一点是,因为迭代才10万,小模型已经逼近极限了,而大模型还有很大的提升空间。

所以我们应该从另外的两个维度去验证模型的差异:

跑相同的时间,再去同一个dst上对比效果。

所有模型都跑到极限,再去同一个dst上对比效果。

这个就靠大家去研究了,5个模型,并行搞实在吃不消。

第二:目标头像太小,体现不出不同像素模型的差异。

虽然大家都知道高参数模型清晰度高,但是很多人可能并不明白为啥高。

假设模型都跑到极限的情况下。如果目标人物的脸部区域只有128,那么即便你用了256的模型,也体现不出太多差别。而如果用256的目标人脸去做对比就会有很大差异了。在这种情况下,128的模型需要把脸放大到256,这个过程肯定会变模糊一些,而256模型,不需要放大,所以就会清晰一些。

当然,有超分加持,两者差异可能不会那么大,但是绝对是有差异。下面我就来对比下当目标图片变大之后的情况。

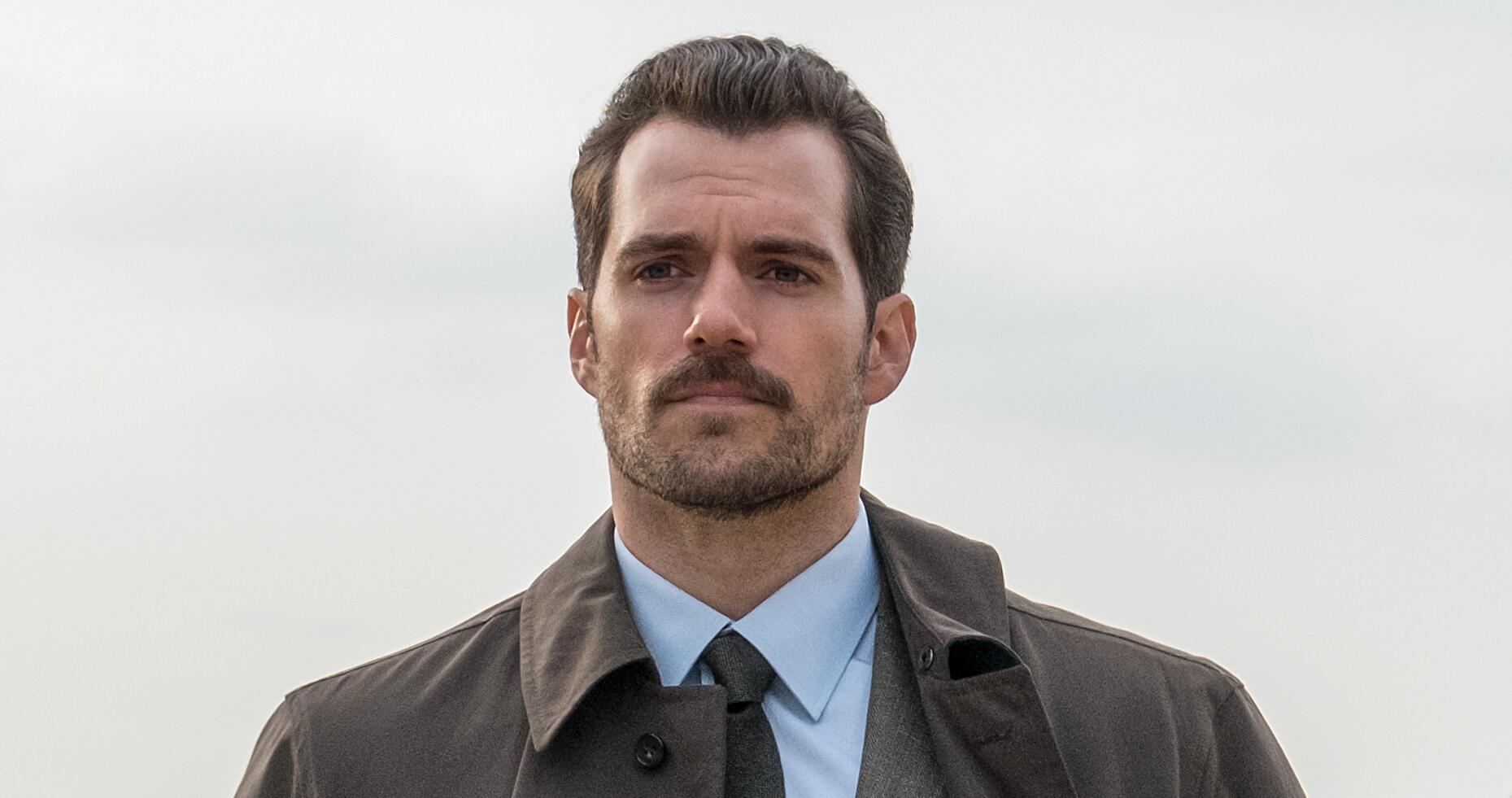

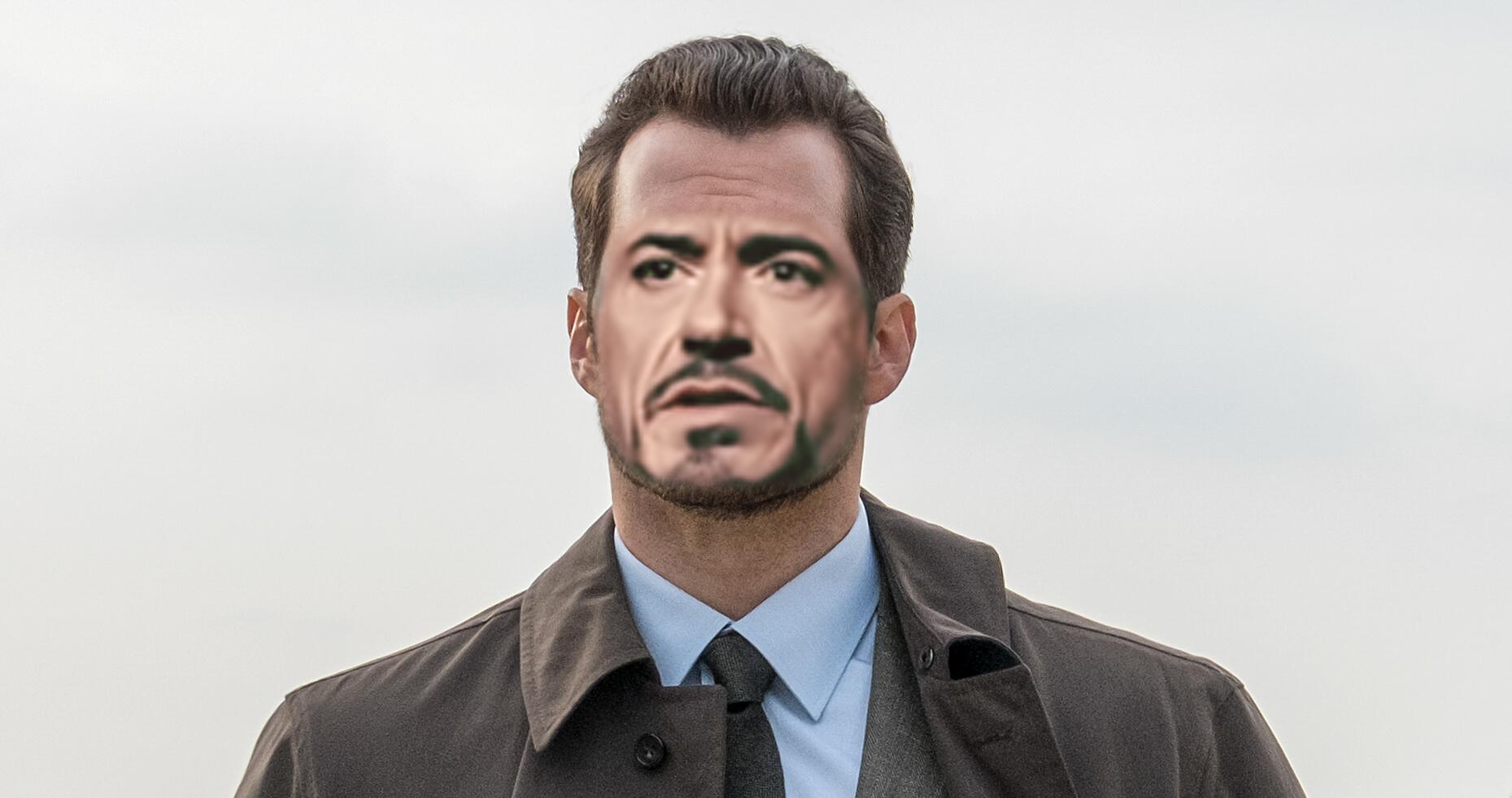

将dst替换为超人,然后每个模型再训练1000个迭代。

Quick96

SAEHD128 DF

SAHE256 DF

原图片,从4K原图中截取了一部分,画面质量还是阔以滴!为了排除其他因素影响,以下合成效果均没有特意调整合成参数。

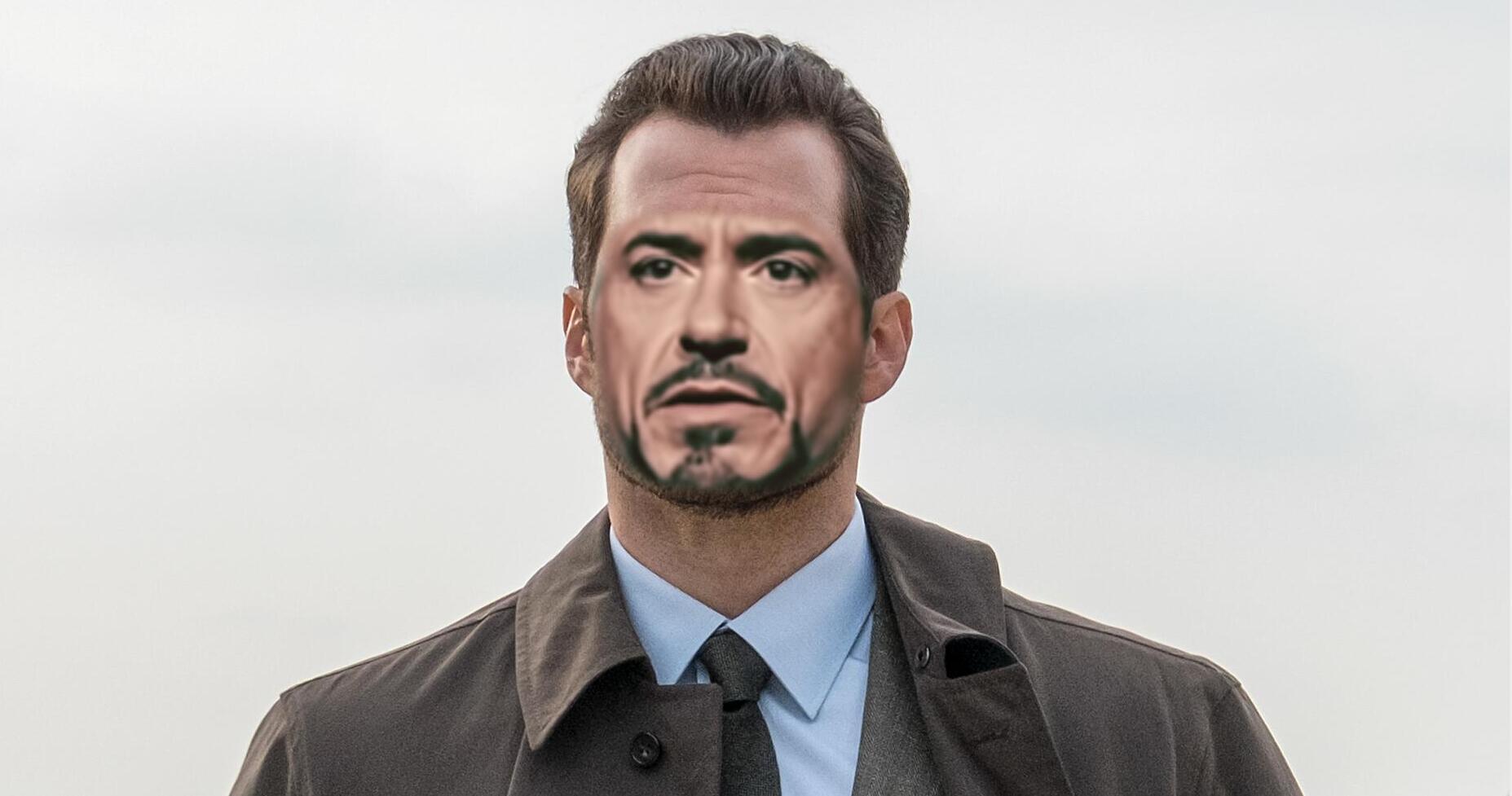

Quick96合成效果,钢铁侠成赵本山…

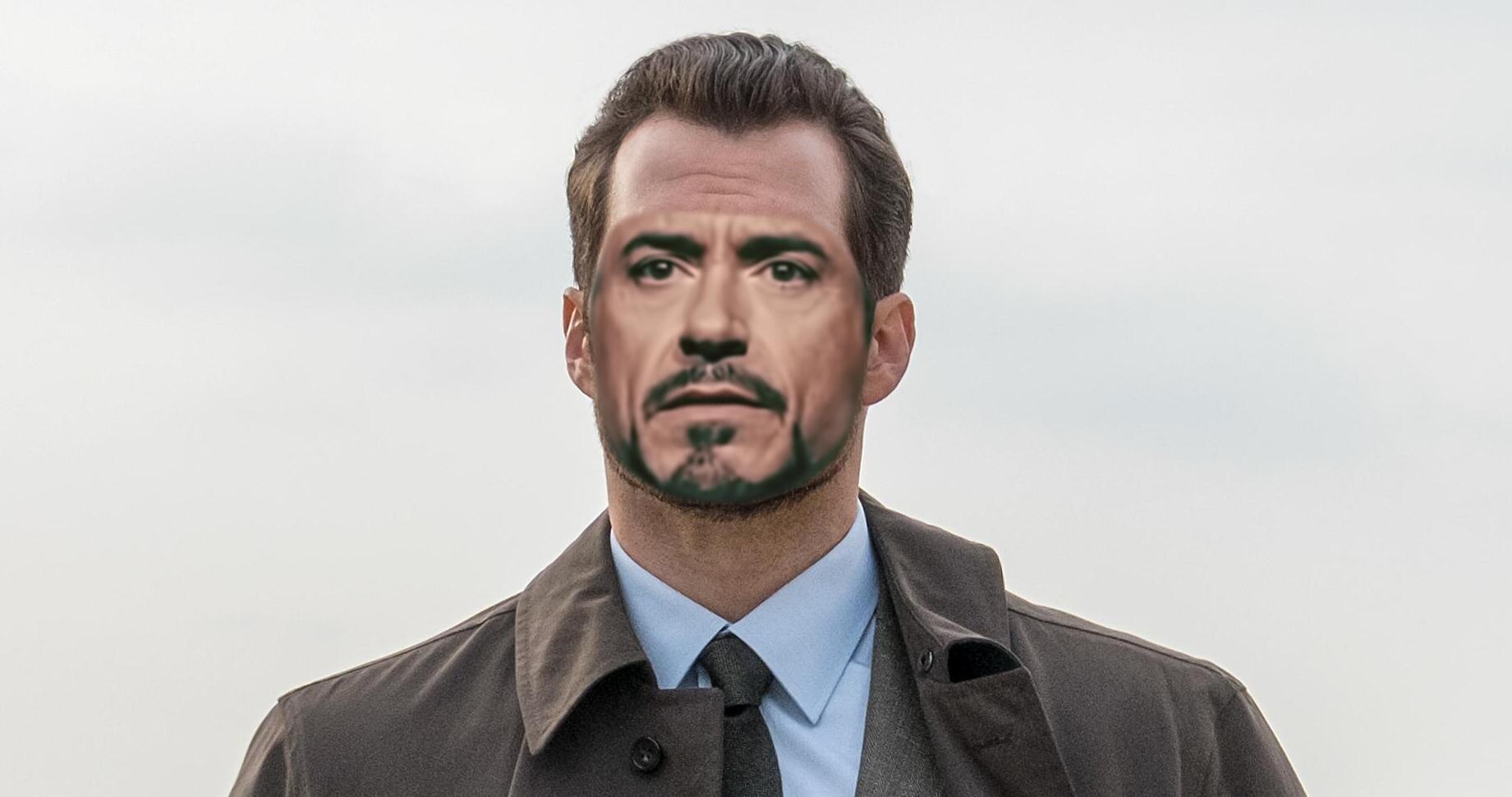

SAEHD 128 合成效果,好了一些!

SAEHD 256合成效果,明显提升。当然,针对这种dst如果要合成图比较完美的效果,需要优化的地方还不少。

当把目标对象改大之后,差异就变得非常明显了。小模型针对这种情况,已经没有太大提升空间了,大模型却还可以通过提高迭代数量来大幅提升效果。所以针对高质量的DST视频,大模型的优势就非常明显。针对低质量的DST视频,小模型就有时间上的优势。

所以这还是一个“平衡游戏” ,根据自己的应用场景选择合适的模型,不要盲目追求高配参数,浪费时间。

这个SAEHD 256改文件哪里,是改文件参数还是训练参数里面的

256是模型的参数,意思是像素256,在第一次开始训练模型的时候可以设置这个参数,后面就不能改了。